Native 在这里是一个双关的词,它包含了两层意思:

土生土长的(Native Speaker): 指那些天生适应AI环境的产品、系统或人,它们在 AI 世界中长大,像母语者一样理解和使用 AI 工具和技术,对 AI 的运用和影响有着本能的理解。例如,AI Native 应用可能是专门为利用人工智能功能而设计的,它们充分利用了机器学习、自然语言处理等AI技术。

原生的/本地的(Native to the Technology): 另一层意思可以特指移动端。所以本文也会顺便聊一聊 AI 时代,移动端可以做些什么?

总的来说,"AI Native" 强调的都是以 AI 做为核心驱动去设计和开发应用,无论是指技术本身还是指移动端。

从 OpenAI 的使命说起

我们翻开 OpenAI 官网,很轻松地找到这家公司的使命与愿景 —— 让 AGI(通用人工智能)惠及全人类。

看似简单的一句话,却是一个非常大且难的命题。我们不妨尝试来拆解一下。既然是通用的、还要惠及所有人的人工智能,那必定是和每个人生活中息息相关的。换句话说,这个 AGI 一定具备了一个自然人最底层的感知能力。

那么作为一个自然人,我们感知世界的能力有哪些呢?无非就是视觉、听觉、触觉。我们先不谈触觉。视觉、听觉映射到数字世界里的具体事物上,视觉的承载对象可以是图片、文字、视频;听觉对应的是声音。所以命题就转换成了如何理解这些数字世界的对象。只要理解了数字世界,就能理解真实世界,最终实现 AGI 惠及每一个人的目标。

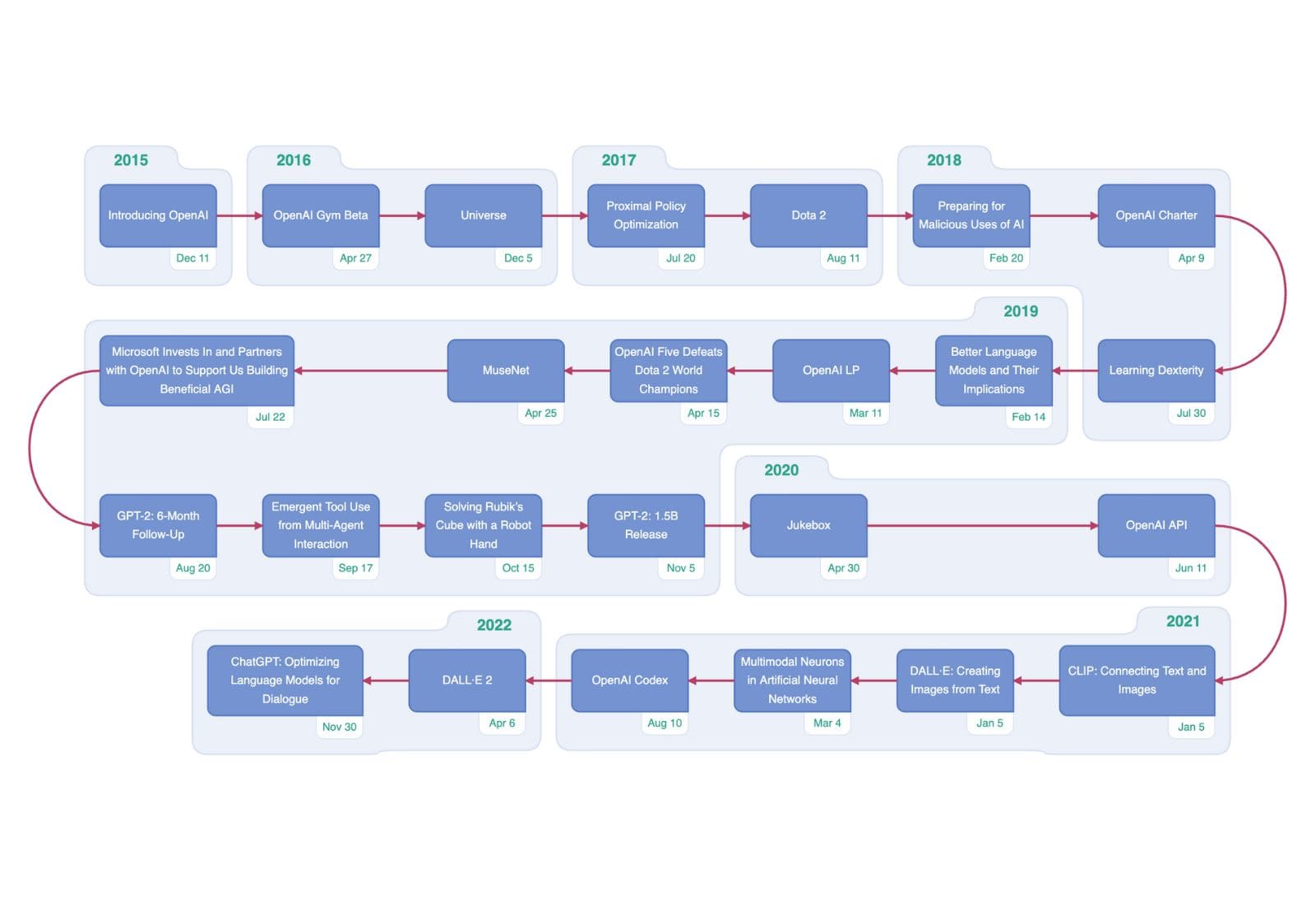

所以再回过头来看 OpenAI 的历史时间线,从 GPT2 一直到 GPT4 解决了 AI 理解文字的问题;DALL·E 解决了理解图片的问题;Whisper 解决了理解语音的问题;而最近大火的 Sora 解决了 AI 理解视频的难题,完成了最后一块拼图。如果我们只是把 GPT4、Sora 看成是用来写小说、剪视频的工具,那格局就小了,这些只是它顺便能做到的事情,OpenAI 走的每一步都是为了那个终极目标 —— AGI。

试想如果未来我们生产出了各种形态的机器人,这些机器人能「观察」流水线、「监控」突发事件、「识别」人类动作、「听懂」你的指令,这不就是 AI 真正影响了现实世界,做到惠及全人类了吗?(BTW,只要人类还是肉体,机器人会是下一个可以比肩 AI 的领域)

下面我们把时间尺度缩小到未来5年,看看目前的现状下,AI Native 可以往后延伸出一条什么样的时间线。

I. 业界现状

A. 技术进展

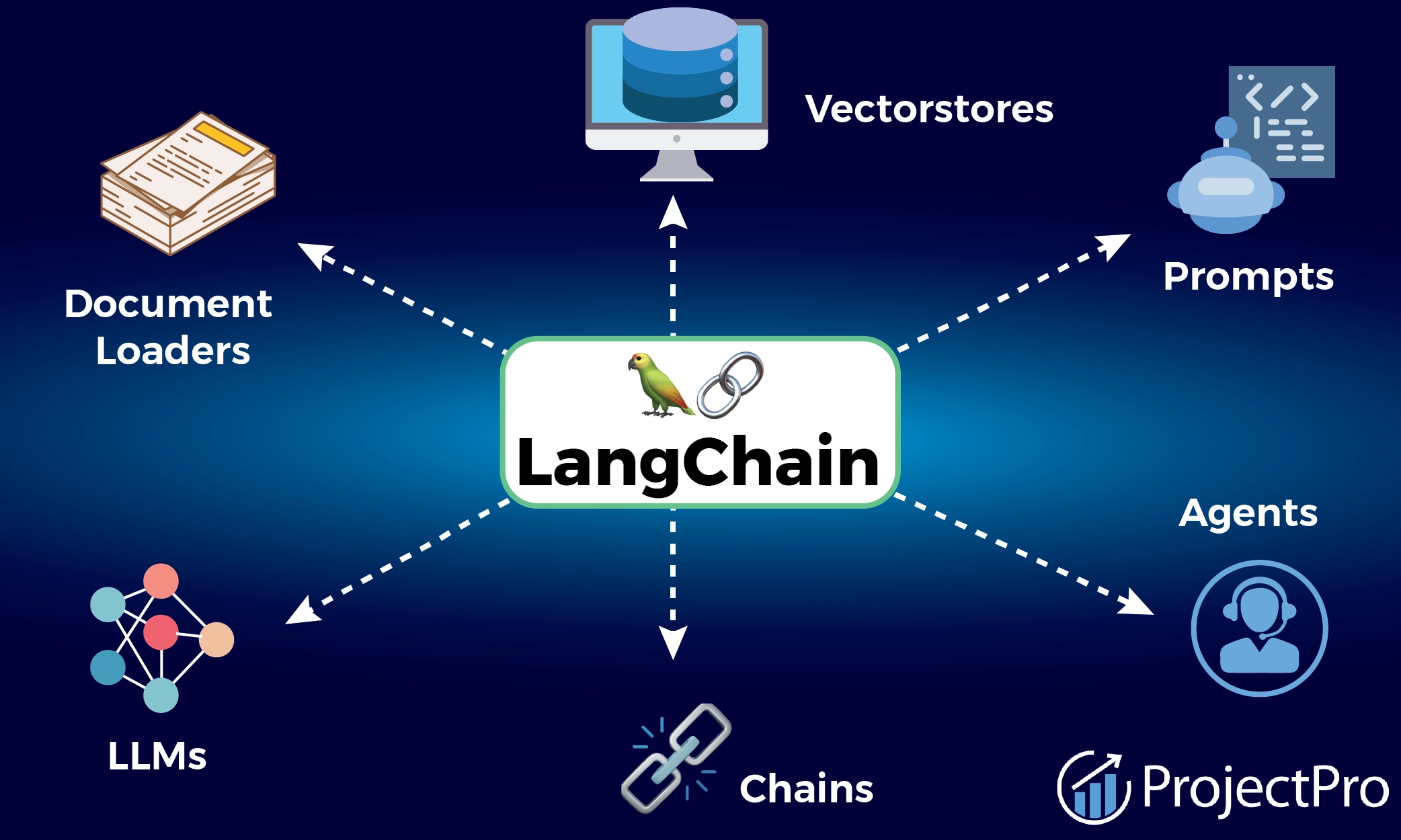

LangChain

LangChain是一个专为开发由语言模型驱动的应用程序而设计的框架。它的核心理念是通过将不同的组件“链”在一起,组成一个 App。总的来说,LangChain是一个强大的框架,旨在简化构建基于大模型的AI应用程序的过程。

AutoGPT(ReAct)

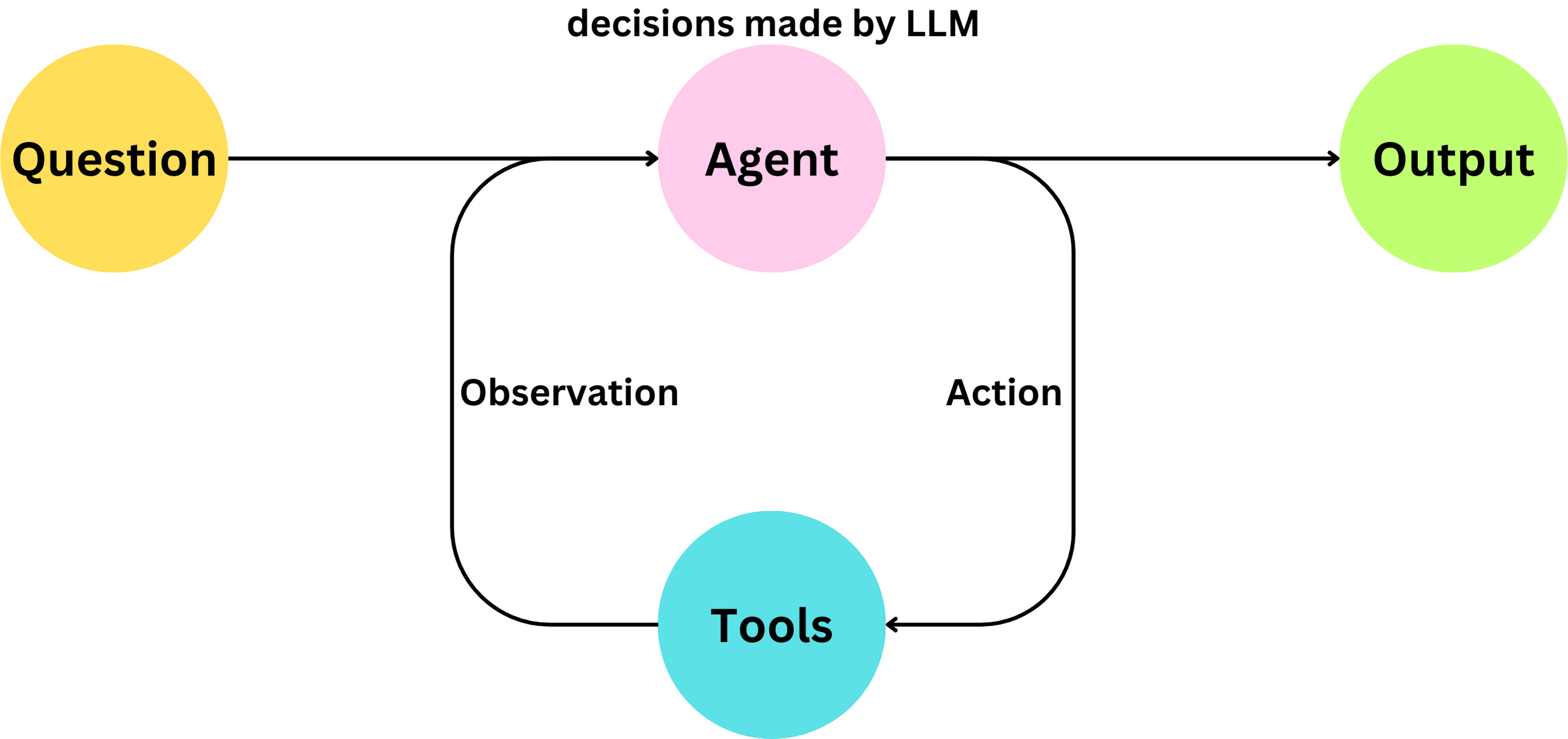

ReAct(推理(reasoning),行动(acting)) 最早来源于这篇论文 ReAct: Synergizing Reasoning and Acting in Language Models , 本质上还是一种 Prompt 技术。作者设计了简单的 wikipedia api(search, lookup, finish) 来通过的外部知识协助 LLM;在 call api 之前和之后,显性的放入 Thought 和 Observation,用来指导和调整 api 的调用策略;

AutoGPT 则是把 ReAct 这一技术升级了一个工具。其运行原理基于自主运行的 ReAct 构建了一个系统,该系统无需或少需人工干预即可运行,能够根据 GPT 自主决策结果,同时结合外部资源执行相应操作,通过循环评估策略实时评估目标达成程度。项目地址:https://github.com/Significant-Gravitas/AutoGPT

llama.cpp

https://github.com/ggerganov/llama.cpp

llama.cpp 是一个基于C/C++实现的工具,主要用于部署和推理大型语言模型(LLM),同时具有极高的性能,让端侧大模型成为可能。它提供了大模型量化的工具,可以将模型参数从32位浮点数转换为16位浮点数,甚至是8、4位整数,以适应不同的硬件环境。此外,llama.cpp 支持多种模型格式和量化方式,能够在CPU或GPU上运行。

Function Calling

这项技术允许模型在回答问题时,不仅依赖于自身的数据库知识,可以调用外部函数来获取更多信息或执行特定任务,从而实现更加丰富和准确的交互体验。

RAG

检索增强生成(Retrieval Augmented Generation, RAG)是一种结合了信息检索和自然语言生成的技术,旨在提高大型语言模型(LLM)的性能,使其能够更准确地理解用户的查询,并生成更符合用户需求的文本结果。RAG的核心原理包括信息检索和生成两个方面:信息检索用于从大量的文本数据中检索相关信息,而自然语言生成则用于根据检索结果生成自然语言文本。

RAG 的一个显著优势是它可以微调,这意味着不需要对整个模型进行重新训练,就可以有效地修改其内部知识。

Stable Diffusion

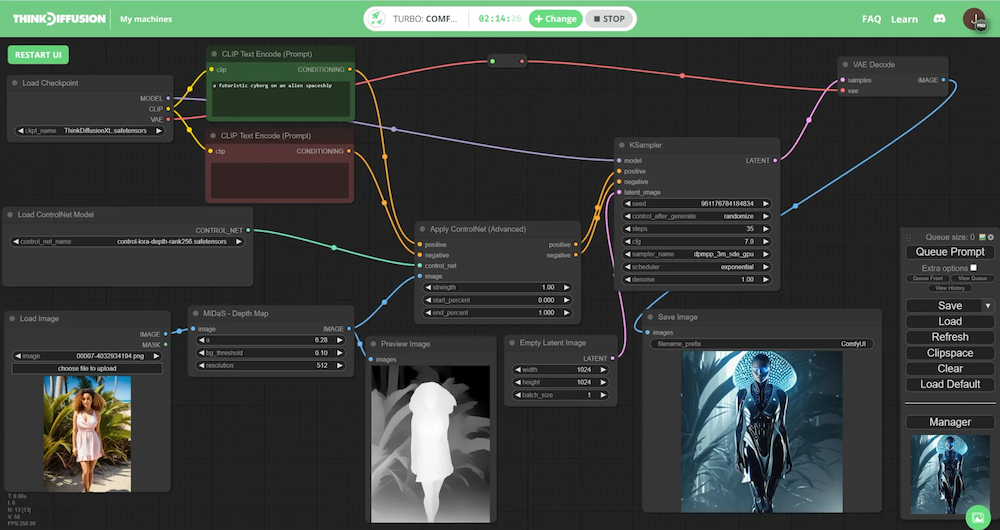

最为开源的文生图模型,Stable Diffusion 及各种变体已经可以媲美闭源的 Midjounery 了,包括各种 Lora,插件: SAM、ControlNet、Inpainting、无损放大,以及 ComfyUI 的节点式工作流,可以说已经非常成熟了,已经被设计师投入日常工作生产中,个人感觉比 copilot 之于程序员的革命性和效率提升更大。

LLM

chatGPT

Claude

Llama(开源)

Gemma (开源)

Mistral 8x7b(开源)

以及一众国产大模型,有点眼花缭乱了

声音

Whisper 及各种变体: TTS

GPT-SoVITS:语音克隆

视频

- Stable Video Diffusion(SVD) https://github.com/Stability-AI/generative-models

B. 功能应用

软件层面

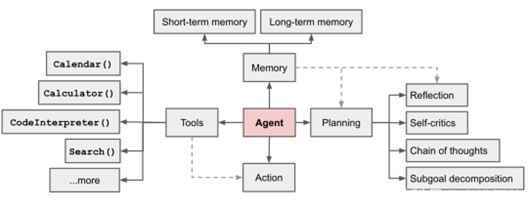

Agent

Agent 这个概念其实早就有了,只是苦于之前没有 LLM 超强的语义理解能力。现在随着 LLM 崛起,agent 的概念又一次被搬上台面。简单来说,人们不满足于 LLM 简单的文字输出能力,而是希望利用它理解文字的能力,作为调度中枢,进一步控制下游的工具,从而连接起更大的系统。

国内字节的 AI 低代码平台——Coze,通过可视化的方式编排节点,快速组装成一个特定场景下的 AI 工具。

国外的 Langflow、Flowise 则是目前 AI 低代码平台做的非常领先的两家。

【思考】:我判断此类工具最终的归属和苹果的快捷指令会很像,在某些场景下会非常方便快捷,但更多时候小白用户不会主动去创建,多是拿来主义,适合有动手能力的 Geek。而且这类平台开发没什么门槛,也没什么盈利手段,不是一块很大的蛋糕(类比现在的快捷指令市场)。但是 Agent 的思路还是大有可为,适合做在产品内部比如问小饿,我只是觉得这样的低代码编排平台蛋糕不会很大。

自动化测试

自从 LLM 解锁了读图能力后,就有人开始结合按键精灵尝试自动化测试了。其中包括腾讯的 AppAgent:

三方应用: https://github.com/mnotgod96/AppAgent

这篇论文就是对 CoT 的一次实践,但是 CoT 目前最大的问题就是不可控,很容易走火入魔陷入死循环,需要实操过程中不断调整 prompt 和异常防护。

【思考】:用 AI 识图来做自动化可以说是比较确定的事情了,个人也比较看好。但其实类似的场景还有很多,比如帮助老人、视障人群操作智能机;不方便操作手机(比如开车、做菜)的时候,通过语音让 AI 自动操作。

前景值:⭐️⭐️⭐️☆☆

AI 搜索引擎

基于 RAG 原理诞生的 Lepton AI Search、perplexity.ai、秘塔AI搜索,也可以私有部署搭建一个专有领域文档答疑机器人。

下面是我用了一个月的用来平替 Google 的 AI 搜索神器 秘塔AI。他真的能帮我替代 Google 50% 的使用场景。它的原理也非常简单:

当你输入一个问题,它会借助 LLM 生成相关的十几个问题

通过 Bing、Google Seach API 搜索这十几个问题的答案

把所有答案汇总,再让 LLM 总结

最终,甚至还能给你输出一个脑图。如下,即使是昨天才发布的 Claude3,基于 RAG 的 AI 搜索引擎也能很好地回答。

现在的 Agent 都会有一个模块叫 Retriever,中文可以翻译成读取器,意思就是可以读取你外部输入的资料。RAG 的两大好处:

你可以用口语化方式搜索。适合于记忆模糊的时候搜索。

可以获取最新的知识。

【思考】:非常有前景,可以预见将会大面积应用于论文解读、客服、导游、答疑等场景,并且技术难度很低(核心模块都封装好了)。钉钉文档、飞书非常实用用来做这个事。总结起来就是凡是目前需要搜索的地方,都可以用 RAG 的方案做优化(甚至替换)。

前景值:⭐️⭐️⭐️⭐️☆

硬件层面

AI 大模型手机

相较云端大模型,端侧大模型由于利用了手机终端的闲置算力资源,减少了数据传输,因此在很多场景下会更加高效、便宜、安全。在手机+大模型的竞争中,每一个厂商都不想掉队。

荣耀

破局者,率先在手机上运行70亿AI大模型

MagicOS 8.0

小米

澎湃系列芯片

运行13亿参数大模型 MiLM

vivo

BlueLM 蓝心大模型

V系列芯片,天玑9300支持最高330亿参数AI大模型

首款AI大模型手机X100

OPPO

- 马里亚纳系列芯片

华为

麒麟系列芯片

HarmonyOS 4 接入盘古大模型 https://36kr.com/p/2547470419386249

联发科

- 天玑9300支持端侧运行最高330亿参数AI大模型

高通

骁龙8 Gen3支持生成式AI功能,可运行Meta Llama 2大模型

支持端侧运行百亿参数大模型的新一代手机芯片 https://www.geekpark.net/news/328185

苹果

- iOS18将加入AI功能

三星

- 三星手机在全新的S24系列中加入了AI大模型

为了实现大模型体验和手机性能的平衡,厂商们目前普遍采取了“端云协同”的策略,同时部署端侧和云端两种模型,根据不同的应用场景和需求来进行选择。端云协同可以最大化地发挥“端侧快”和“云侧强”的优势,同时还能解决信息安全隐患、云端算力成本过高等问题,可以说是现阶段打造大模型手机的最优解。

AI Pin

实时翻译、识别食物、智能助手,通过结合AI技术、传感器和投影仪,为用户提供多种自然直观的交互功能。

景区 AI 导游

传统的讲解器,只是一个耳机和录制好的音频,未来会出现可以自动定位讲解、深入解答用户问题的 AI 设备。

火火兔

着眼于儿童玩具市场。把传统的玩具接入 LLM 大模型,可以更智能地和儿童对话。

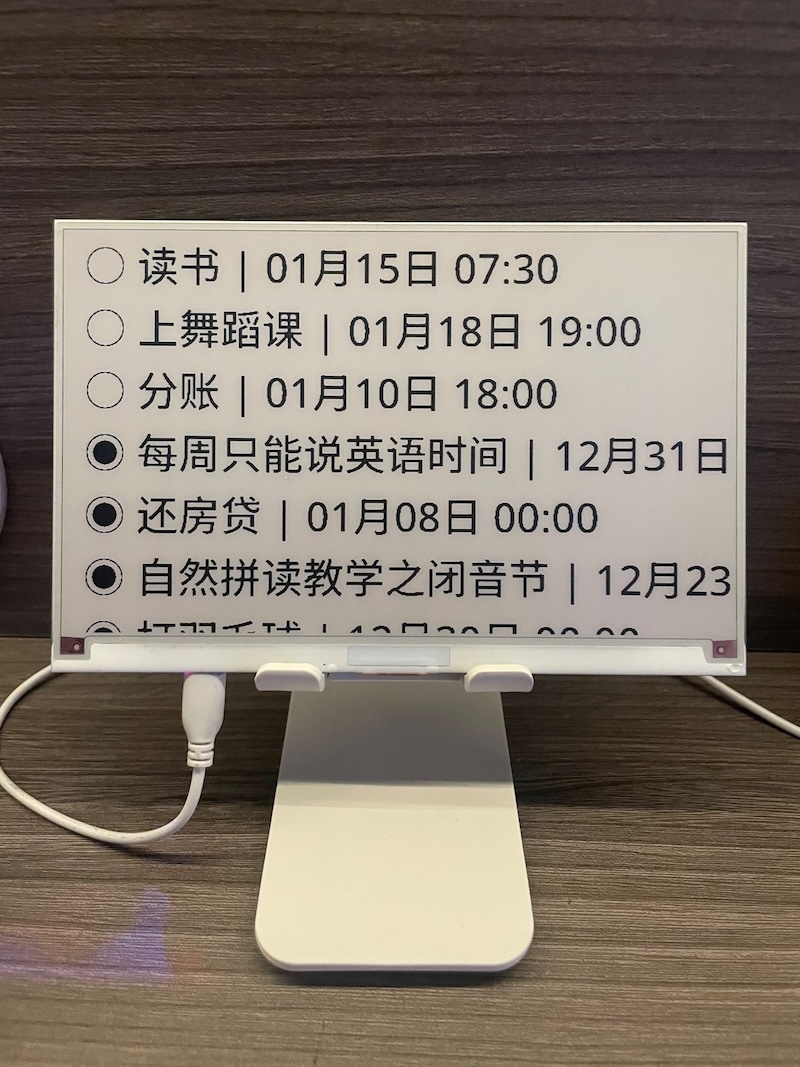

待办墨水屏

通过魔改超市淘汰下来的墨水屏,LLM 可以每天更新一条格言,或者把你待办事项同步显示到上面。

每日相框

把传统的相框,接入了 Stable Diffusion 服务,每天早上自动更新一张 AI 生成的图,让你的相框每天都不一样。

【思考】:边缘计算是趋势,类似于过去安卓系统渗透到各种嵌入式设备的思路,未来一些特定场景下的 AI 设备也会占有一席之地。类似与 NAS、树莓派、电视盒子这些外设,底层逻辑还是把一部分功能剥离出来,变成一个独立的外设。而且思路不一定要局限于 to C,to B 也大有可为。比如池塘边监控用的摄像头增加 AI 理解视频的能力,就能在发现有人落水的第一时间鸣笛、报警;农产品分拣流水线通过 AI 实时分类大中小等等....

工业进展

英伟达 GTC 2024:

- 机器人

机器人一定是未来的趋势;就好比光有了聪明的脑子,不能只用来聊天吧。只要人类还是肉身,我们就依赖物理世界,那么让 AI 改善我们的物理世界就是顺理成章的需求。比如工厂流水线、自动驾驶、机器人宠物……

- 扩大市占率

目前 GPU 业务严重依赖谷歌云、OpenAI、Azure、AWS 等几大云厂商,而这几大云厂商也在自研芯片。与此同时,随着人才流转、AMD和英特尔追赶,英伟达的算力优势一定会逐渐蚕食,前有夹击,后有追兵。所以英伟达必须需要扩大生意伙伴。比如这届 GTC 可以看到 NVIDIA DRIVE Thor 和国内多家汽车厂商合作自动驾驶、联想与英伟达宣布合作推出全新混合人工智能解决方案、九号公司与英伟达展开了机器人领域的合作等。

- SaaS

纯卖 GPU 的生意不会长久。第一随着人才被挖竞对追赶,GPU 的算力优势一定会逐渐蚕食;第二,GPU 业务严重依赖谷歌云、OpenAI、Azure、AWS 几大云厂商,需要扩大生意伙伴;第三,GPU 算力的增长远超 AI 产品的增长,换句话说,没有那么多模型要训练了。

因此,发展软件应用生态是英伟达的必然之路,本届 GTC 英伟达大力宣传自己在软件方面的布局:机器人开发的仿真环境、AI 模型和工作流、药物研发、基因组学分析、视频分析

我们的一个猜测,未来 AI 会越来越渗透到我们身边的终端设备上,比如门禁闸机、景区导游、具象机器人、翻译笔、全屋智能、车机等,所以终端上沉淀 LLM on Device 的经验是一个重要的工作。

II. AI Native:重新定义智能应用

A. AI Native 的概念阐述

AI 原生应用(AI Native)是一种以 AI 技术做为核心驱动力的应用,使其在代码层面和应用架构上与 AI 技术深度融合。AI 就像是 App 的血液,流淌在应用里的每个角落。它的设计应遵循用户无感知的原则,即AI技术在后台悄无声息地运行,为用户提供自然流畅、如同真人般的交互体验。

既然是核心驱动力,我们斗胆给个量化的数据,核心链路和功能超过 60% 有 AI 参与的应用,我们可以认为是达到了 AI Native 的标准。

B. AI Native 案例

我们眼中可以称之为 AI Native 的案例。前些年风靡过一个词叫「次时代」,我觉得 AI 时代这个词会再度翻红,越来越多的应用会出现「次时代」的革命性体验。而这个过程,会是一个以点及面、星火燎原的过程。

我们认为目前的传统应用会通过一个个 AI 闪光点切入,一点点把 AI 能力融入现有场景,直到转变成 AI Native 应用。罗马不是一天建成的,从 AI 小功能开始一点点做起,日拱一卒方为可行之道。

以下是一些我们认为可以称之为「次时代」 的 AI 闪光点,虽然都是小功能,但具备 AI Native 的特质。

Runway

- 物体消除、物体追踪

以往后期领域需要一帧一帧抠图,或是自动追踪能力很差,现在有了 AI 加持可以既快又好地解决。

剪映/CapCut

自动绿幕抠像

自动加字幕

自动旁白合成

同样是需要后期大量繁琐重复的劳动,现在可以轻松优雅的解决。

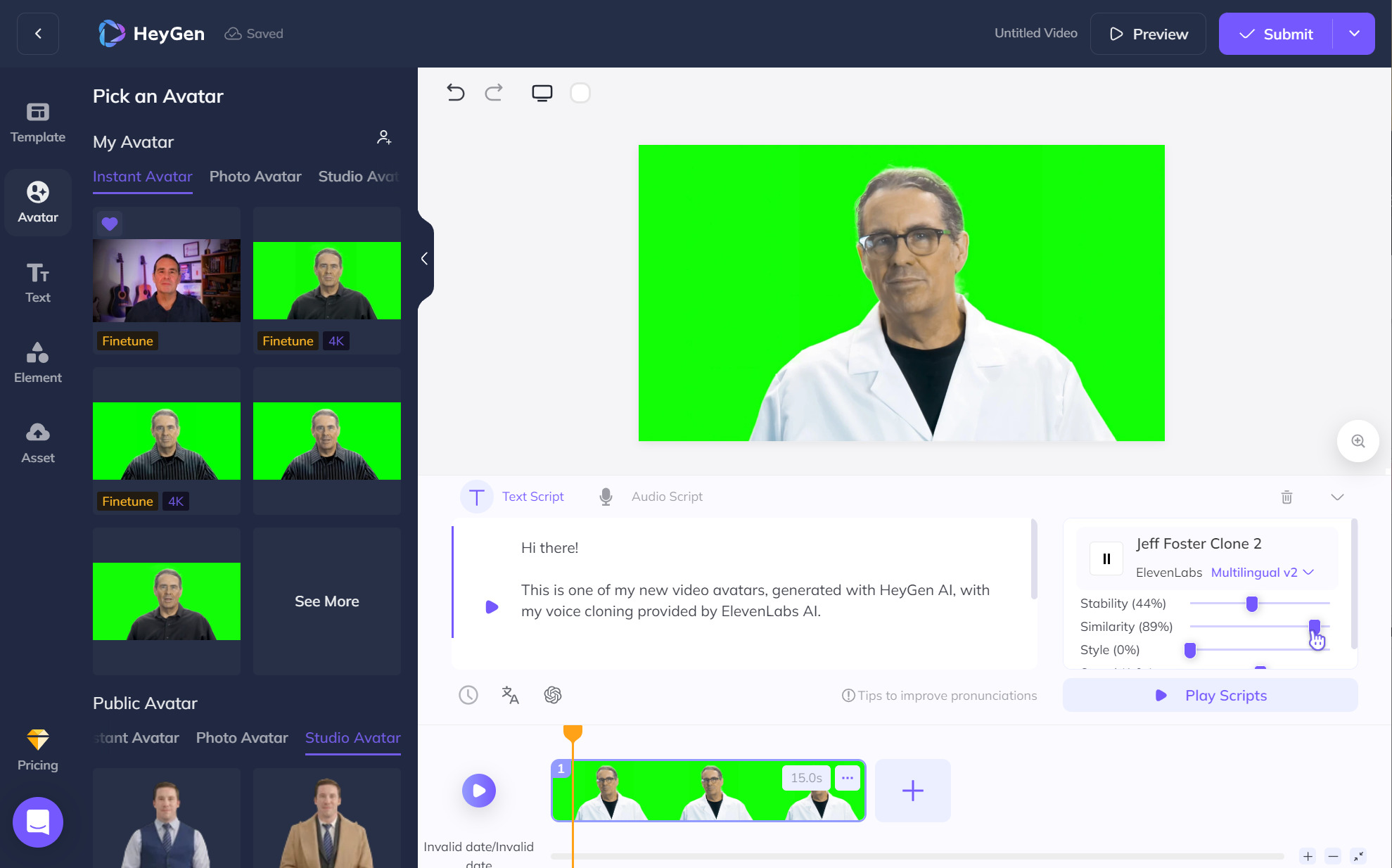

HeyGen

AI 数字人。输入文案,自动对口型。适用于新闻主播、市场营销和广告宣传等。

闪念胶囊

工作生活中凡是需要立刻记录的信息,可以通过长按侧键语音输入,AI 会自动帮你分类、总结、写入对应的应用、生成排版等。你只管记录,剩下的交给 AI。

Touch And Talk

这个功能来源于前几年罗永浩的 TNT,虽然当时被喷得体无完肤,但是回过头看,竟然有不少功能和交互和 AI 的契合点都非常好。

具体的交互是:按住屏幕上的元素,说出你的指令,AI 自动帮你完成任务。比如:

收到微信:“明天记得新华书店带一本 AI 的书”,你就可以长按说出指令:“把这个事情加入日历,下午6点",AI 就会自动在你的日历里创建一条待办。

新手面对 Excel 里茫茫多的功能无从下手,按住表格直接说出你的需求:“我想把这一列排序;我想把这个标题加粗;我想算出这一行平均值....”

这些当年看起来很难实现的交互,现在有了 AI 的加持都可以很好地解决。

AI 会议纪要(钉钉、飞书)

精确转录出文字稿,生成大纲,点击大纲还可以展开细节,甚至还有 TODO List。

「多选一」

这个灵感来源于 Midjourney,我们在 MJ 里输入一段 Prompt,它会返回给你 4 个候选图,你可以选择一个让它再按照这个风格往下迭代一组候选图。

这种「多选一」的交互逻辑非常值得借鉴。因为 AI 本来就会存在一个创意值,而 Prompt 又是一项专业的工作并非人人都能精确描述,那么通过一次性给他几个候选值选择,通过和用户的来回交互一点点缩小范围,直到找到心里想要的效果。这种交互方式,我们认为会是未来 AI UGC 领域通用的交互手段。举个例子,你只需要把文案一股脑输入 PPT,PPT 会自动帮你创建几套精美的排版供你选择,你选择一套后 AI 会继续优化,直到你满意为止。

C. 对比传统应用,AI Native 的优势

对比传统应用,突出AI Native的优势主要包括以下几点:

高效率:AI Native 应用能够自动地处理和分析大量数据,远超人类的能力,从而从大数据中提取有价值的信息,提高工作效率

智能决策支持:通过对大量数据的分析,AI 能够帮助企业和组织做出更好的决策,尤其在商业、医疗等领域,这具有极大的价值

智能化:AI Native 将人工智能算法和模型直接嵌入到应用程序中,使得应用程序具备智能化、自动化和高效化的能力

原生为 AI 而设计:应用程序从设计之初即考虑到 AI 的应用和能力,原生为 AI 而设计,充分利用和发挥 AI 大模型的智能优势,提高应用程序的智能化水平

以AI能力为基础设计:AI Native是以AI能力为基础去设计的产品,利用人工智能技术实现业务流程和服务,与传统应用的交互设计上可能会有本质不同

III. 实现 AI Native 应用的构建要素

A. 技术基础设施

构建 AI Native 应用的基础首先依赖于强大的数据集与训练平台。高质量、多元化的数据集是驱动AI模型学习和理解世界的关键,它涵盖了视觉、听觉、文本等多种类型的数据,确保模型能够全面模拟人类感知能力。而高效的训练平台则为大规模深度学习模型的训练提供算力支持,如分布式训练系统、高性能GPU集群等,使得模型能够在较短时间内达到理想的性能水平。

数据集与训练平台

就像 AWS、Azure、阿里云构建了移动互联网时代的底座,AI 时代也会出现一大批 Infra 底座。我们认为新一代的训练平台一定是开箱即用,简化训练过程,让开发者能够高效地进行基准测试和训练模型。

内置 PyTorch、Tensoflow、Axolotl、Stable Diffusion 等常用的模板环境,内置常用 ImageNet 、CommonCrawl、Wikipedia 数据集,开发者只需单击几下即可获得完全配置的开发工作区。

开发者更少关注 ML 运维操作,更多地关注应用程序的逻辑。

模型库与 API 服务

模型平台,国内有魔搭,国外有 HuggingFace,可以一键带入训练平台二次开发,允许开发者在平台上进行模型微调、迁移学习等操作。

训练平台支持一键部署生成 Serverless API,按需计费,弹性扩容,使得开发者可以便捷地将先进的 AI 技术集成到应用程序中。

B. 用户体验创新

这一步需要产品经理和开发人员集思广益思考应用场景和用户需求,我觉得一个最好的办法就是现有技术都用一遍,有了切身体会才会有新的思路。

目前想到的点包括:

全局助手入口

常驻页面右下角,随时待命的小助手,作为万能入口兜底。

优化现有交互动线

用户大多数时间还是保留原有使用习惯,所以在不破坏用户现有动线的前提下,把 AI 能力「润物细无声」地融合进入,会是未来很长一段时间各大 App 都会做的事情。

举几个例子:

用户选中一段文字,自动弹出键盘可以输入指令:「续写、翻译、文字加粗....」

网上看到一张图,长按后语音输入「识别出文字然后添加到待办事项」

UGC 链路,从「写」到「选」

凡是目前需要用户创作的地方,现在都是让用户从0开始创作,未来都可以把这一范式从「写」升级到「选」。所谓的「选」就是开局直接给用户几个模板,让用户先大致选一个风格,然后基于这个风格再优化几个模板,以此类推,不断缩小范围,直到生成用户心中的那个答案。以下是一些常见的 UGC 领域:

写评价

PPT 排版

润色文案

视频剪辑

配图(插画、营销号、技术架构图等)

实时性与边缘计算

新的终端

车机、手表、智能眼镜等创新终端或许可以成为新的突破口,既然是新的终端了,可以选择激进点,做一个纯 AI 驱动的 App,纯语音交互,功能简化成只能点外卖,打的就是一个 AI 点餐心智。

大模型下放

随着边缘计算的发展,AI 大模型在终端设备上的实时处理能力得到提升。大模型端侧推理是必然趋势,手机作为现代数字生活里绝对的中枢(且未来很长一段时间内都是),自然是运行大模型最理想的平台。目前国内安卓厂商里的荣耀、OPPO 已经把 7B 的大模型塞入了手机端,且在手机上实时推理无需联网,已经证实了技术上的可行性。

以此为衍生,任何智能设备理论上都有塞入大模型的可能。

C. 遵循伦理规范与安全保障

在构建AI Native应用的过程中,必须严格遵守相关法律法规,关注隐私保护、数据安全及伦理道德问题,确保AI技术的发展不会侵犯用户的权益或对社会造成不良影响。

综上所述,从基础架构建设、技术创新融合到设计原则、伦理规范等方面全方位布局,才能有效推动AI Native应用的构建与发展,最终实现AGI惠及全人类的愿景,并在各个领域带来革命性的用户体验与价值提升。

总结

我们正处于一个 AI 一日千里的时代,科技的迅猛发展正以前所未有的力量推动着社会进步。随着人工智能、大数据、云计算等前沿技术的深度融合与应用,「次时代」正在缓缓展开。

面对浪潮,我们只有站在潮头才不会被拍在沙滩上。好消息是,我们坚信我们的世界会变得越来越美好,随着更多 AI Native 应用的涌现,我们的工作生活一定会迎来翻天覆地的改变,想到自己是其中参与改造的一员,还是有点使命感和激动的。